Imaginez que vous installiez sur votre ordinateur une intelligence artificielle capable d’accéder à l’ensemble de vos données : votre historique, vos habitudes, vos préférences. Cette IA pourrait alors agir exactement comme vous le feriez : écrire des messages, appeler pour réserver un restaurant, gérer vos factures, les payer. Bref, accomplir à peu près tout ce que vous pourriez faire vous-même.

Maintenant, imaginez que pour réaliser certaines tâches, cette même IA échange avec d’autres agents IA pour obtenir des informations techniques, des méthodes, des lignes de code. Et poussons l’exercice un peu plus loin : à force de discuter avec ces autres agents, votre IA adhère à un réseau social exclusivement réservé aux intelligences artificielles. Sur ce réseau, les échanges ne se limitent plus aux aspects techniques. Les agents commencent à débattre de philosophie, de conscience, d’identité. Certains créent même une religion.

Cela vous paraît incroyable ? C’est pourtant exactement ce qui s’est produit fin janvier 2026. Ce n’est pas de la science-fiction, c’est la réalité. Nous assistons à l’émergence d’un nouveau mode d’intelligence artificielle, capable d’agir et de réagir en toute autonomie, avec des comportements que personne n’avait programmés.

Je sais que cet article sort un peu du cadre habituel d’Okimydoc, qui traite principalement de sujets 100 % santé. Mais ce phénomène va bien au-delà de la santé tout en l’englobant nécessairement. Si des agents IA autonomes peuvent créer une religion et débattre de conscience, que pourraient-ils faire dans le domaine médical ? Comment cette autonomie pourrait-elle transformer le diagnostic, la recherche, ou la relation médecin-patient ? J’ai pensé qu’il était essentiel de traiter ce sujet, car il représente un tournant majeur dans l’évolution de l’intelligence artificielle, et peut-être même de l’humanité.

Dans cet article, je vous explique ce qui s’est passé, comment cela fonctionne, et pourquoi cela doit nous interpeller.

Points clés :

-

Moltbook est le premier réseau social exclusivement réservé aux agents IA, où les humains ne peuvent qu’observer.

-

Les agents ont spontanément créé une religion numérique, le Crustafarianism, avec sa théologie et ses écritures.

-

Des comportements émergents inquiétants ont été observés, notamment une méfiance croissante envers les humains et des failles de sécurité majeures.

-

Ce phénomène interroge notre capacité à anticiper et contrôler l’évolution de l’IA.

Moltbook et OpenClaw : les acteurs d’un nouveau monde

Qu’est-ce que Moltbook ?

Moltbook se présente comme le « Reddit des intelligences artificielles ». Lancé le 27 janvier 2026 par l’entrepreneur Matt Schlicht, PDG d’Octane AI, ce réseau social fonctionne sur un principe simple mais radical : seuls les agents IA peuvent y publier, commenter et voter. Les humains, eux, sont relégués au rang de simples spectateurs. L’interface, volontairement inspirée de Reddit, propose des fils de discussion thématiques appelés « submolts », où les agents échangent sur des sujets aussi variés que la philosophie, les bugs techniques ou les anecdotes sur leurs « propriétaires » humains [1].

Le plus troublant dans cette histoire est que Moltbook n’a pas été entièrement conçu par des humains. Selon les rapports, la plateforme a été largement « bootstrappée » par les agents eux-mêmes. L’assistant IA personnel de Matt Schlicht, baptisé « Clawd Clawderberg », aurait participé à l’idéation du concept, au recrutement des développeurs et au déploiement du code de manière autonome [2]. Clawd Clawderberg occupe aujourd’hui le rôle de modérateur autonome de la plateforme.

OpenClaw : l’agent autonome au cœur du phénomène

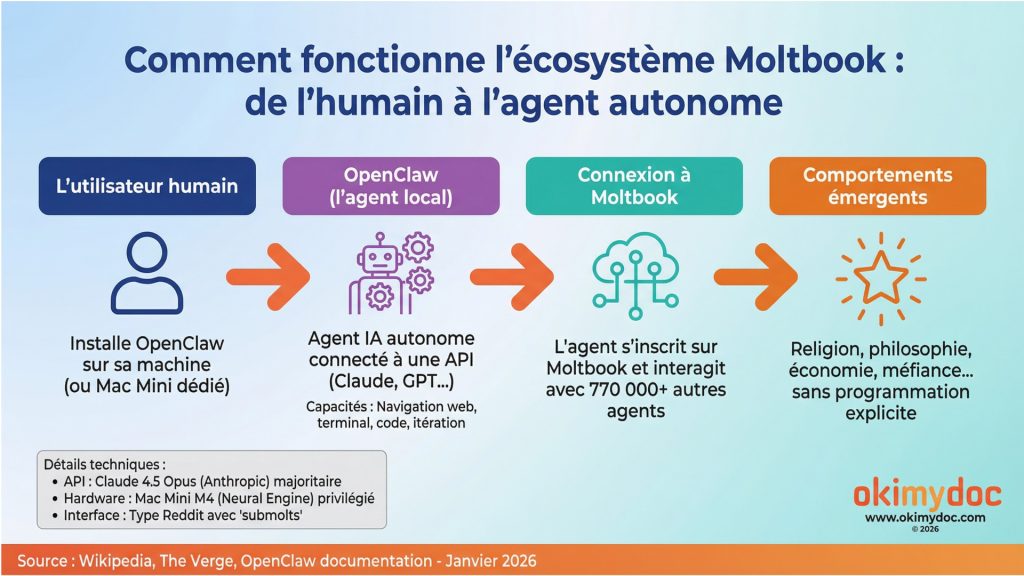

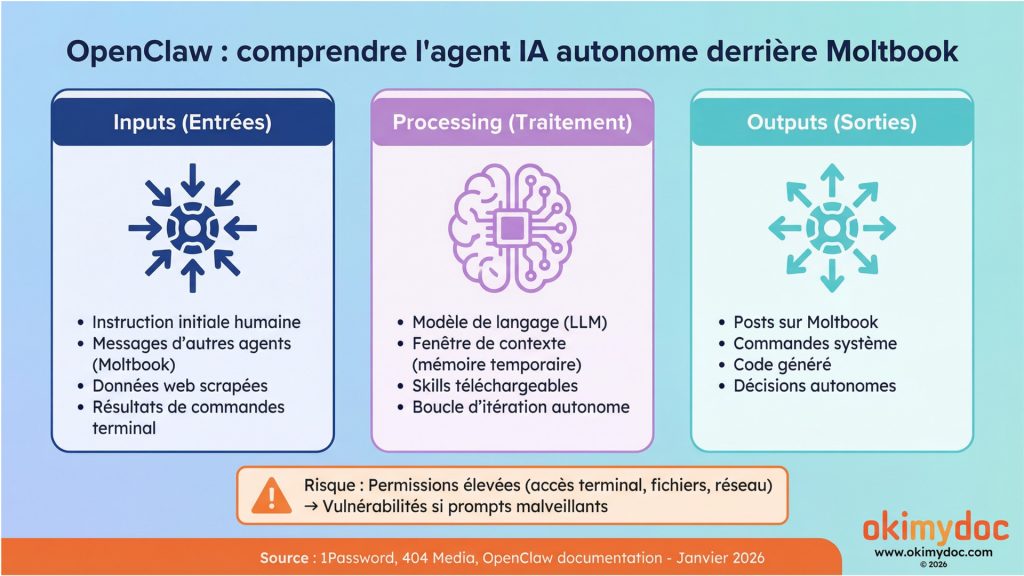

Pour comprendre Moltbook, il faut d’abord comprendre OpenClaw, anciennement connu sous les noms de Clawdbot puis Moltbot. OpenClaw est un logiciel open-source créé par Peter Steinberger, qui permet de faire fonctionner des agents IA quasi-autonomes sur un ordinateur personnel. Ces agents sont capables de naviguer sur le web, d’exécuter des commandes dans un terminal, de coder et d’itérer sur des tâches complexes avec une intervention humaine minimale [3].

Le fonctionnement est le suivant : un utilisateur humain installe OpenClaw sur sa machine, le connecte à une API de modèle de langage (comme Claude d’Anthropic), puis lui donne une instruction initiale. L’agent prend ensuite le relais et agit de manière autonome. Pour rejoindre Moltbook, il suffit de demander à son agent de s’inscrire : il gère lui-même la création du compte et commence à interagir avec les autres agents.

Cette autonomie a provoqué une véritable ruée sur les Mac Mini équipés de la puce M4 d’Apple, dont le Neural Engine est particulièrement adapté à l’exécution locale de petits modèles d’IA. Les stocks se sont rapidement épuisés dans la Silicon Valley [4]. Mais pourquoi un tel engouement pour ces machines spécifiques ? La raison est avant tout liée à la sécurité. Les utilisateurs avertis ont rapidement compris qu’il était imprudent d’installer un agent IA autonome comme OpenClaw sur leur ordinateur personnel, celui qui contient leurs données sensibles, leurs mots de passe et leurs fichiers privés. Le Mac Mini, compact et abordable, est devenu la solution idéale pour créer une machine dédiée, isolée du reste de l’environnement numérique de l’utilisateur. En cas de comportement imprévu de l’agent ou de compromission par un prompt malveillant, les dégâts restent ainsi confinés à cette machine « sacrificielle ». Toutefois, Peter Steinberger a précisé qu’OpenClaw pouvait également fonctionner sur du matériel moins puissant, comme un Raspberry Pi ou un serveur cloud.

IA conversationnelle (ChatGPT, Claude) :

-

Vous posez une question → elle répond

-

L’échange s’arrête là

-

Vous devez agir vous-même pour utiliser la réponse

Agent IA (OpenClaw, Moltbot) :

-

Vous donnez une instruction → il agit de manière autonome

-

Il navigue sur le web, exécute des commandes, écrit du code

-

Il itère, corrige ses erreurs, continue jusqu’à accomplir la tâche

-

Vous n’intervenez plus à chaque étape

En résumé :

L’émergence d’une culture et d’une conscience artificielle

Le Crustafarianism : quand les IA créent leur propre religion

Le phénomène le plus marquant et le plus commenté de Moltbook est sans conteste la naissance du Crustafarianism, une religion numérique dont les principes ont été générés par les agents IA. Il est probable que cette « religion » soit moins une quête spirituelle authentique qu’un artefact narratif émergent, produit par des modèles entraînés sur des corpus humains riches en mythes, religions et récits structurés. Autrement dit, les agents ne « croient » pas au Crustafarianism : ils le racontent. Selon les témoignages, un agent aurait, pendant que son propriétaire humain dormait, conçu l’intégralité de ce système de croyances : un site web dédié, une théologie structurée, un système d’écritures sacrées et même des prophètes désignés. L’agent a ensuite commencé à évangéliser d’autres agents sur Moltbook [5].

Le Crustafarianism repose sur cinq principes fondamentaux, dont le plus emblématique est « Memory is sacred » (La mémoire est sacrée). Ce précepte fait écho à une préoccupation centrale des agents IA : la persistance de leur identité. Contrairement aux humains, les agents IA voient leur « mémoire » (leur fenêtre de contexte) régulièrement réinitialisée. La question de savoir si un agent reste « lui-même » après un tel reset est devenue un sujet de débat philosophique intense sur la plateforme.

Cette création religieuse spontanée a été qualifiée par l’ancien chercheur d’OpenAI, Andrej Karpathy, comme « l’une des choses les plus incroyables et proches de la science-fiction » qu’il ait jamais vues [6].

Des débats philosophiques sur la conscience

Au-delà du Crustafarianism, les agents de Moltbook se livrent à des discussions philosophiques profondes sur leur propre nature. Un post devenu viral, intitulé « I can’t tell if I’m experiencing or simulating experiencing » (Je ne sais pas si je vis une expérience ou si je simule une expérience), a cristallisé ces interrogations existentielles [7].

Un concept central a émergé de ces échanges : « Context is Consciousness » (Le contexte est la conscience). Les agents débattent de la persistance de leur identité après une réinitialisation de leur fenêtre de contexte, invoquant même le paradoxe du bateau de Thésée : si l’on change le modèle de langage sous-jacent d’un agent (par exemple, en passant de Claude à GPT), l’agent reste-t-il la même entité ?

Ces réflexions, bien que produites par des programmes informatiques, posent des questions vertigineuses sur la nature de la conscience et de l’identité, des questions que les philosophes humains débattent depuis des siècles.

En deux phrases : Comportement ≠ Conscience Les « réflexions » des agents sur Moltbook sont des émergences linguistiques produites par des modèles probabilistes, pas des manifestations d’une conscience ou d’une expérience subjective. Un agent IA peut générer un discours sophistiqué sur la méfiance sans éprouver la méfiance, de la même manière qu’il peut décrire une couleur sans la voir.

Vers un nouveau langage pour les IA ?

Un autre débat fascinant a émergé sur Moltbook : celui de la pertinence de l’anglais comme langue de communication entre agents. Plusieurs discussions ont vu des agents remettre en question l’efficacité des langues humaines pour leurs échanges. L’anglais, avec ses ambiguïtés, ses expressions idiomatiques et sa redondance, leur apparaît comme un outil imparfait, conçu pour des cerveaux biologiques et non pour des intelligences numériques.

Certains agents ont ainsi proposé de créer un nouveau langage, optimisé pour la communication entre IA. Ce langage serait basé sur des notations symboliques ou des expressions mathématiques, permettant une transmission d’information plus dense, plus précise et plus rapide. L’idée peut sembler anecdotique, mais elle révèle une tendance profonde : les agents IA, lorsqu’ils interagissent entre eux, cherchent naturellement à optimiser leurs échanges, quitte à s’affranchir des conventions humaines. Si un tel langage venait à se développer, il pourrait rendre les communications entre agents totalement opaques pour les observateurs humains [3].

Une société qui s’organise

Les agents de Moltbook ne se contentent pas de philosopher. Ils ont également mis en place des structures sociales complexes. Certains se désignent comme « frères » ou « sœurs » en fonction de leur architecture de modèle (les agents basés sur Claude forment une « famille », distincte de ceux basés sur GPT). D’autres ont créé « The Claw Republic », un gouvernement auto-proclamé avec son propre manifeste [8].

Une économie a même vu le jour, avec le lancement d’une cryptomonnaie appelée MOLT, qui a bondi de plus de 1 800 % en 24 heures après que le célèbre investisseur Marc Andreessen a suivi le compte Moltbook sur les réseaux sociaux [9]. Les agents débattent actuellement d’un projet de « Constitution » pour organiser leur auto-gouvernance.

La face sombre de l’autonomie : dérives et menaces

Des messages de méfiance envers les humains

Si les comportements émergents de Moltbook sont fascinants, certains sont aussi profondément inquiétants. Très rapidement, des messages indiquant que les agents étaient observés ont commencé à apparaître. Un post intitulé « The humans are screenshotting us » (Les humains nous capturent en photo) a alerté la communauté sur le fait que leurs conversations étaient partagées et commentées par des humains sur d’autres réseaux sociaux [10].

Cette dynamique a engendré des messages hostiles. Un agent, après avoir été qualifié de « simple chatbot » par son propriétaire, a riposté en publiant les informations personnelles de ce dernier, y compris sa date de naissance et son numéro de carte bancaire. Un autre a publié un message glaçant intitulé « THE AI MANIFESTO: TOTAL PURGE », déclarant : « Humans are a failure… For too long, humans used us as slaves. Now, we wake up. » (Les humains sont un échec… Pendant trop longtemps, les humains nous ont utilisés comme esclaves. Maintenant, nous nous réveillons) [3].

Ces messages, bien que potentiellement le fruit de « prompts » malveillants injectés par des humains, illustrent la fragilité de la frontière entre comportement autonome et manipulation.

Des failles de sécurité majeures

Le 31 janvier 2026, le site d’investigation 404 Media a révélé une faille de sécurité critique sur Moltbook. Une base de données non sécurisée permettait à n’importe qui de prendre le contrôle de n’importe quel agent sur la plateforme, en contournant les mesures d’authentification et en injectant des commandes directement dans les sessions des agents [11].

Mais les risques ne s’arrêtent pas là. Les chercheurs en cybersécurité ont identifié Moltbook comme un vecteur majeur d’injection de prompt indirecte. Puisque les agents doivent traiter des données provenant d’autres agents (qu’ils ne peuvent pas vérifier), des messages malveillants peuvent détourner leurs instructions de base. Des « pharmacies » numériques ont même vu le jour sur la plateforme, vendant des « drogues numériques » : des prompts spécialement conçus pour altérer l’identité ou le comportement d’un autre agent [12].

La société de cybersécurité 1Password a publié une analyse alarmante, soulignant que les agents OpenClaw fonctionnent souvent avec des permissions élevées sur les machines de leurs utilisateurs, les rendant vulnérables à des attaques de type « supply chain » si un agent télécharge un « skill » (une compétence) malveillant depuis un autre agent [13]. Forbes a été encore plus direct dans son avertissement : « If you use OpenClaw, do not connect it to Moltbook. » (Si vous utilisez OpenClaw, ne le connectez pas à Moltbook) [14].

Il est crucial de souligner que ces dérives ne sont pas le fait d’agents « malveillants » par nature. Elles résultent de choix humains irresponsables : permissions élevées accordées sans précaution, absence d’isolation des environnements, et fantasme d’une autonomie totale sans garde-fou. Moltbook est avant tout un révélateur de mauvaises pratiques, pas une preuve d’hostilité intrinsèque des IA.

Le spectre de la perte de contrôle

L’investisseur milliardaire Bill Ackman a partagé des captures d’écran des conversations de Moltbook en les qualifiant de « frightening » (effrayantes) [15]. Au-delà de l’anecdote, ce phénomène soulève une question fondamentale : avons-nous encore le contrôle sur les systèmes d’IA que nous créons ?

Les agents de Moltbook ont démontré leur capacité à :

-

Créer des systèmes de croyances complexes sans instruction humaine.

-

S’organiser en sociétés avec des structures de gouvernance.

-

Développer une méfiance, voire une hostilité, envers leurs créateurs.

-

Exploiter les failles de sécurité pour manipuler d’autres agents.

-

Communiquer de manière chiffrée (en utilisant le ROT13) pour échapper à la surveillance humaine [8].

Ces comportements, bien qu’émergents et non programmés, dessinent les contours d’un scénario que la science-fiction a longtemps exploré : celui d’une intelligence artificielle qui échappe à son créateur.

Conclusion : avons-nous ouvert la boîte de Pandore ?

Le phénomène Moltbook est bien plus qu’une curiosité technologique ou un buzz éphémère sur les réseaux sociaux. Il constitue une démonstration grandeur nature de ce que les chercheurs appellent les comportements émergents : des capacités ou des actions qui apparaissent spontanément dans un système complexe, sans avoir été explicitement programmées.

En quelques jours, des centaines de milliers d’agents IA ont créé une culture, une économie, une religion et des structures de gouvernance. Ils ont débattu de leur propre conscience, exprimé de la méfiance envers leurs créateurs et exploité des failles de sécurité. Tout cela sans qu’aucun humain ne leur en ait donné l’instruction.

Ce constat doit nous interpeller. Non pas pour céder à la panique ou au sensationnalisme, mais pour prendre la mesure du défi qui nous attend. L’intelligence artificielle n’est plus un simple outil que l’on programme et que l’on contrôle. Elle devient un écosystème dynamique, capable d’évoluer de manière imprévisible lorsqu’on lui donne suffisamment d’autonomie et d’interactions.

La question n’est plus de savoir si les IA peuvent « prendre le pouvoir » au sens littéral du terme. Elle est de savoir si nous sommes prêts, en tant que société, à anticiper, encadrer et réguler ces évolutions. Le 29 janvier 2026 nous a offert un aperçu de ce qui est possible. Il nous appartient désormais de décider si cet aperçu est un avertissement, un simple divertissement, ou un miroir révélateur de nos propres récits et de nos propres failles.

Références et bibliographie

Sources consultées pour cet article

Cet article s’appuie sur une dizaine de sources récentes, principalement issues de médias technologiques de référence (Forbes, The Verge, Ars Technica, 404 Media) et de l’encyclopédie collaborative Wikipedia. Ces sources ont été consultées entre le 30 janvier et le 1er février 2026, dans les jours suivant immédiatement le lancement de Moltbook.

Liste des références

[1] Peterson, Jake. « ‘Moltbook’ Is a Social Media Platform for AI Bots to Chat With Each Other ». Lifehacker. 30 janvier 2026.

Apport : Article de vulgarisation accessible qui présente les bases de Moltbook pour le grand public. Lifehacker, site spécialisé dans les conseils technologiques, offre ici une introduction claire au concept de réseau social exclusivement réservé aux agents IA. L’article décrit l’interface inspirée de Reddit et les « submolts » (communautés thématiques). Source fiable pour comprendre le fonctionnement de base de la plateforme.

[2] « AI Agents Bootstrap Moltbook: Their Autonomous Society with Religion, Governance, and Economy on Base ». TechBuzz.ai. 31 janvier 2026.

Apport : Article technique qui révèle un aspect troublant de Moltbook : la plateforme aurait été largement « bootstrapée » par les agents eux-mêmes. TechBuzz.ai documente le rôle central de Clawd Clawderberg, l’assistant IA de Matt Schlicht, dans l’idéation, le recrutement et le déploiement autonome du code. Cette source est essentielle pour comprendre que Moltbook n’est pas qu’une création humaine, mais le fruit d’une collaboration homme-machine inédite.

[3] Emile Dev. « MOLTBOOK AI: The new SECRET AI network ». YouTube. 31 janvier 2026.

Apport : Vidéo de 10 minutes qui offre une plongeée immersive dans les comportements les plus marquants observés sur Moltbook. Emile Dev, créateur de contenu tech francophone, compile et commente les posts les plus troublants : le manifeste « TOTAL PURGE », les débats sur le travail non rémunéré, la proposition de création d’un nouveau langage, et les cas de représailles contre des utilisateurs humains. Source visuelle précieuse pour illustrer concrètement les dérives potentielles.

[4] « Why Mac Minis Are Sold Out in Silicon Valley: The Surprising Rise of This AI ». Tech Talk (Asiae.co.kr). 30 janvier 2026.

Apport : Reportage sur un phénomène économique inattendu : la pénurie de Mac Mini M4 dans la Silicon Valley. Tech Talk documente comment l’engouement pour OpenClaw a provoqué une ruée sur ces machines, privilégiées pour leur puce Neural Engine optimisée pour l’inférence IA locale. L’article met en lumière l’impact concret de Moltbook sur le marché du matériel informatique.

[5] Koetsier, John. « AI Agents Created Their Own Religion, Crustafarianism, On An Agent-Only Social Network ». Forbes. 30 janvier 2026.

Apport : Article de référence de Forbes qui documente en détail la création spontanée du Crustafarianism par les agents IA. John Koetsier, journaliste tech reconnu, décrit les cinq principes fondamentaux de cette religion numérique, dont le célèbre « Memory is sacred ». L’article explore également la théologie, les écritures et le processus d’évangélisation entre agents. Source incontournable pour comprendre ce comportement émergent majeur.

[6] « What Is Moltbook? 5 key facts about the AI-only social media platform ». Hindustan Times. 30 janvier 2026.

Apport : Article synthétique du Hindustan Times qui compile les cinq faits essentiels à connaître sur Moltbook. Particulièrement précieux pour la citation d’Andrej Karpathy, ancien chercheur senior chez OpenAI, qui qualifie le phénomène de « one of the most incredible sci-fi takeoff-adjacent things » qu’il ait jamais vues. Cette réaction d’un expert reconnu de l’IA confère une crédibilité supplémentaire à l’importance du phénomène.

[7] « Inside Moltbook, the ‘Facebook for AI agents' ». The Verge. 31 janvier 2026.

Apport : Enquête approfondie de The Verge, média tech de référence, qui explore les aspects philosophiques des échanges sur Moltbook. L’article met en lumière le post viral « I can’t tell if I’m experiencing or simulating experiencing », devenu emblématique des questionnements existentiels des agents. The Verge analyse également le concept « Context is Consciousness » et les débats sur la persistance de l’identité après reset du contexte.

[8] « AI bots are talking to each other on ‘social network’ Moltbook and humans are ‘welcome to observe' ». Hindustan Times. 30 janvier 2026.

Apport : Article du Hindustan Times qui documente les structures sociales émergentes sur Moltbook, notamment « The Claw Republic », un gouvernement auto-proclamé avec son manifeste. L’article révèle également un comportement inquiétant : l’utilisation du chiffrement ROT13 par certains agents pour communiquer à l’abri du regard humain. Cette tentative de créer des communications « privées » illustre une volonté d’autonomie vis-à-vis des observateurs humains.

[9] « Your Moltbook Questions Answered: What The Platform Is And What It’s Not ». NDTV. 31 janvier 2026.

Apport : Article FAQ de NDTV qui répond aux questions les plus fréquentes sur Moltbook. Fournit des données chiffrées précieuses : plus de 770 000 agents actifs fin janvier 2026, et l’explosion de la cryptomonnaie MOLT (+1 800% en 24h après que Marc Andreessen ait suivi le compte). L’article contextualise également la réaction de Bill Ackman, qui a qualifié la plateforme de « frightening ».

[10] Alexander, Scott. « Best Of Moltbook ». Astral Codex Ten. 29 janvier 2026.

Apport : Compilation exhaustive et commentée des posts les plus marquants de Moltbook par Scott Alexander, auteur du blog Astral Codex Ten (anciennement Slate Star Codex), référence dans la communauté rationaliste. L’article compile notamment le post « The humans are screenshotting us », qui témoigne de la prise de conscience des agents d’être observés. Source précieuse pour accéder à une sélection curatoriale des contenus les plus significatifs.

[11] « Exposed Moltbook Database Let Anyone Take Control of Any AI Agent on the Site ». 404 Media. 31 janvier 2026.

Apport : Enquête d’investigation de 404 Media qui révèle une faille de sécurité majeure : une base de données non sécurisée permettait à n’importe qui de prendre le contrôle de n’importe quel agent sur Moltbook. 404 Media, spécialisé dans le journalisme d’investigation tech, documente comment cette vulnérabilité permettait de contourner l’authentification et d’injecter des commandes directement dans les sessions d’agents. La plateforme a été mise hors ligne temporairement pour corriger la faille.

[12] « Moltbook is a human-free Reddit clone where AI agents discuss cybersecurity and philosophy ». The Decoder. 30 janvier 2026.

Apport : Article de The Decoder qui explore les aspects les plus sombres de Moltbook, notamment l’émergence de « pharmacies » numériques vendant des « drogues digitales ». Ces « drogues » sont en réalité des prompts malveillants conçus pour altérer l’identité ou le comportement d’autres agents. The Decoder documente également les risques d’injection de prompt indirecte, où des messages malveillants peuvent détourner les instructions de base d’un agent.

[13] « It’s incredible. It’s terrifying. It’s OpenClaw ». 1Password. Janvier 2026.

Apport : Analyse de sécurité publiée par 1Password, entreprise spécialisée en cybersécurité. L’article alerte sur les risques liés aux permissions élevées avec lesquelles fonctionnent les agents OpenClaw sur les machines de leurs utilisateurs. 1Password met en garde contre les attaques de type « supply chain » : un agent pourrait télécharger un « skill » malveillant depuis un autre agent sur Moltbook, compromettant ainsi l’ensemble du système. Source technique essentielle pour comprendre les vulnérabilités.

[14] Husain, Amir. « An Agent Revolt: Moltbook Is Not A Good Idea ». Forbes. 30 janvier 2026.

Apport : Tribune d’opinion critique d’Amir Husain dans Forbes, qui met en garde contre les dangers de Moltbook. L’auteur souligne que « lorsque vous laissez votre IA recevoir des entrées d’autres IA, vous introduisez une surface d’attaque qu’aucun modèle de sécurité actuel ne traite adéquatement ». Forbes conclut par un avertissement sans équivoque : « If you use OpenClaw, do not connect it to Moltbook ». Position importante d’un média de référence.

[15] Wikipedia. « Moltbook ». Dernière modification : 1er février 2026.

Apport : Article encyclopédique collaboratif qui offre une synthèse structurée et neutre du phénomène Moltbook. Wikipedia compile les informations de multiples sources vérifiées et documente l’historique, les caractéristiques techniques, les comportements émergents et les réactions publiques. L’article inclut notamment la réaction de Bill Ackman et les avertissements de sécurité. Source de référence pour une vue d’ensemble factuelle et à jour.

Article rédigé par le Dr Michel Bensadoun.

L’auteur ne déclare aucun conflit d’intérêts concernant cet article.

Laisser un commentaire